Lernen, Verstehen und Interagieren

Ein KI-Agent ist ein autonom handelndes System, das Umgebungsinformationen aufnimmt, interpretiert und daraus gezielte Aktionen ableitet.

6. Mai, 2025 JBS![]() Beta Version

Beta Version

Ein KI-Agent ist ein autonom handelndes System, das Umgebungsinformationen aufnimmt, interpretiert und daraus gezielte Aktionen ableitet.

Ein KI-Agent ist ein System der künstlichen Intelligenz, das dazu konzipiert ist, seine Umgebung mithilfe von Sensoren wahrzunehmen und daraus Bedeutung zu extrahieren.

In der Debatte über künstliche Intelligenz drängen sich seit einigen Jahren Begriffe wie "Agentensysteme", "autonome Agenten" und "multiagentenbasierte Systeme" in den Vordergrund.

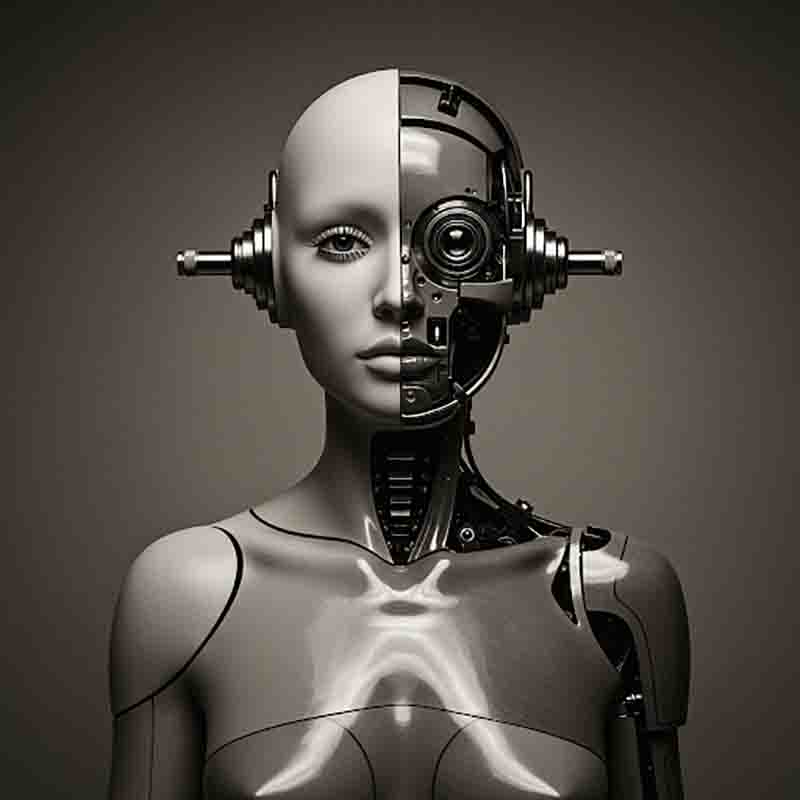

KI Agenten sind Maschinen, die handeln. Systeme, die lernen. Programme, die Entscheidungen treffen, ohne auf jeden Befehl zu warten.

Was vor wenigen Jahrzehnten noch der Science-Fiction vorbehalten war, ist heute Teil konkreter Anwendungen, von autonomen Robotern über intelligente Softwareassistenten bis hin zu komplexen Entscheidungsmodellen in der Industrie.

Im Zentrum dieser Entwicklung steht ein Konzept: Der KI Agent

Ein KI-Agent ist mehr als nur ein Algorithmus

Seine Entscheidungen basieren nicht bloß auf festgelegten Regeln, sondern auf Methoden des maschinellen Lernens, probabilistischen Modellen und Datenanalyse.

Er verfolgt Ziele, bewertet Alternativen und kann sein Verhalten an veränderte Bedingungen anpassen.

Wenn die Funktionsweise eines KI-Agenten undurchsichtig ist ("Black Box"), können Nutzer seine Entscheidungen und Empfehlungen nicht nachvollziehen oder hinterfragen.

Finanzwesen: Agenten analysieren Marktbewegungen, handeln automatisch und passen Strategien in Echtzeit an.

Gesundheitssektor: Virtuelle Assistenten helfen bei der Terminplanung, Diagnoseunterstützung und Therapieempfehlungen.

Logistik: Autonome Systeme optimieren Lieferketten, Routen und Lagerprozesse.

Bildung: Adaptive Lernplattformen passen sich dem Kenntnisstand des Nutzers an und fördern individualisiertes Lernen.

Energie: Agenten in Stromnetzen balancieren Lasten, regeln Einspeisungen und optimieren Verbrauch.

Landwirtschaft: KI-Agenten tragen zu einer effizienteren, nachhaltigeren und rentableren Landwirtschaft bei.

Tourismus: KI-Agenten personalisieren das Reiseerlebnis im Tourismus durch maßgeschneiderte Empfehlungen und optimierte Dienstleistungen.

Diese Entwicklungen sind nicht bloß technologische Neuerungen. Sie fordern ein Umdenken in Organisationen, Rollenverteilungen und ethischen Normen.

Die Nutzung und Anwendung von KI wird darüber entscheiden, welches Prinzip stärker zum Ausdruck kommt. Wird KI eingesetzt, um Prozesse zu optimieren und zu kontrollieren (apollinisch), oder um neue, unkonventionelle und möglicherweise disruptive Innovationen zu schaffen (dionysisch)?

Der Weg zu einer verantwortungsvollen Agentenlandschaft führt nicht allein über Technologie. Er verlangt auch juristische Klarheit, ethische Reflexion und gesellschaftlichen Diskurs.

Die Entwicklung von KI-Agenten begann lange vor dem heutigen Hype um Künstliche Intelligenz.

Schon 1943 legten McCulloch und Pitts mit einem mathematischen Modell künstlicher Neuronen den Grundstein für lernfähige Systeme.

1950 stellte Alan Turing mit seinem berühmten Test erstmals die Frage, ob Maschinen denken können. Dies öffnete die Tür für das Konzept des „handelnden“ digitalen Akteurs.

| Ereignis | Beschreibung |

|---|---|

| 1943 | Erste mathematische Modellierung künstlicher Neuronen, theoretische Grundlage für lernfähige Agenten. |

| 1950 | Turing schlägt ein Kriterium für maschinelle Intelligenz vor, frühe Vorstellung eines „denkenden Agenten“. |

| 1956 | Geburtsstunde der KI-Forschung. Erste Experimente mit symbolischen Agenten (z. B. Logic Theorist). |

| 1960er | Erster physischer KI-Agent mit Wahrnehmung, Planung und Bewegung, entwickelt am SRI International. |

| 1972 | Textbasierter Agent, der Sprache versteht und mit einer virtuellen Welt interagiert, Meilenstein für Agenten mit Sprachverarbeitung. |

| 1980er | Abkehr von rein symbolischen Ansätzen: Brooks' "Subsumption Architecture" ermöglicht handlungsfähige Agenten ohne zentrale Kontrolle. |

| 1986 | Das Belief-Desire-Intention-Modell (Rao & Georgeff) bildet ein kognitives Framework für Agenten mit Zielen und Überzeugungen. |

| 1986 | Das Belief-Desire-Intention-Modell (Rao & Georgeff) bildet ein kognitives Framework für Agenten mit Zielen und Überzeugungen. |

| 1990 | Fokus auf Agenten, die miteinander kommunizieren, verhandeln und gemeinsam Probleme lösen. |

| 1995 | Entwicklung eines Standards für verteilte Agentensysteme auf Java-Basis, heute noch in Lehre und Prototyping verbreitet. |

| 1997 | Symbolisch arbeitender Agent schlägt erstmals einen Weltmeister im Schach, markanter Moment für KI-Leistung. |

| 2000er | Agentenmodelle werden in Simulation, Finanzmodellierung, Verkehrsplanung und Logistiksystemen eingesetzt. |

| 2012 | Beginn datengetriebener KI-Agenten mit lernfähigen Modellen, neuronale Netze werden praxistauglich. |

| 2014 | KI-Agenten mit natürlicher Sprache erreichen Endnutzer, Kombination aus Sprachverarbeitung, Entscheidungslogik und cloudbasierter Intelligenz. |

| 2016 | KI-Agent auf Basis von Deep Reinforcement Learning meistert Go, bisher nicht durch klassische Agentensysteme lösbar. |

| 2020er | KI-Agenten steuern Drohnen, Fahrzeuge, Chatbots, Finanz- und Sicherheitssysteme, zunehmend mit Echtzeit-Fähigkeiten. |

| Heute | Forschung an Agenten mit Theory-of-Mind, adaptiver Interaktion, personalisiertem Verhalten und ethischer Entscheidungsfähigkeit. |

Die Zukunft liegt in der Entwicklung sozialer Agenten, die nicht nur handeln, sondern auch menschliches Verhalten interpretieren und ethisch reflektierte Entscheidungen treffen können.

Ein KI-Agent ist ein System, das in einer Umgebung wahrnimmt, entscheidet und handelt, um ein Ziel zu erreichen.

Diese drei Komponenten, Wahrnehmung, Entscheidungsfindung und Handlung, bilden das Grundgerüst.

Anders als klassische Softwareprogramme, die lediglich auf Eingaben reagieren, verfügen Agenten über ein internes Modell der Welt.

Sie verfolgen eigene Absichten, verwalten Zustände über die Zeit hinweg und interagieren mit anderen Akteuren.

Manche Systeme arbeiten allein, wie ein Routenplaner, der sich dynamisch an Verkehrsdaten anpasst.

Andere agieren im Kollektiv: In der Robotik kommunizieren etwa Schwärme von Drohnen, um komplexe Aufgaben zu koordinieren.

In beiden Fällen ist der KI-Agent mehr als nur ein Werkzeug. Er ist Teil eines Entscheidungsnetzwerks, das mit der Welt in Beziehung tritt.

Der Begriff des Agenten entstammt ursprünglich der Philosophie und Linguistik.

In der Handlungstheorie bezeichnet ein Agent einen Akteur mit Intention, jemanden, der nicht bloß reagiert, sondern absichtsvoll handelt.

In der Informatik griff man dieses Konzept auf und übersetzte es ins Digitale.

Schon in den 1980er Jahren begannen Forscher, Systeme zu entwickeln, die verteilte Entscheidungsprozesse simulieren konnten.

Frühere Anwendungen fanden sich in der industriellen Fertigung, später in der Telekommunikation und Logistik.

Mit wachsender Rechenleistung und neuen Lernmethoden wie Reinforcement Learning öffneten sich weitere Anwendungsfelder.

Heute steuern KI-Agenten Börsenhandelssysteme, digitale Assistenten, autonome Fahrzeuge und adaptive Spielcharaktere.

Doch nicht jeder Algorithmus ist automatisch ein Agent.

Ein KI-Agent muss ein gewisses Maß an Autonomie besitzen. Er darf nicht ausschließlich fremdbestimmt agieren.

Ebenso ist Kontextsensitivität gefragt: Ein Agent sollte Informationen aus seiner Umgebung aufnehmen und auf Veränderungen reagieren können.

Dabei kommt es auf ein Gleichgewicht an: Zu viel Autonomie kann unvorhersehbares Verhalten verursachen.

Zu wenig führt zu bloßer Automatisierung ohne Entscheidungsspielraum.

Die Grenze verläuft dort, wo Systeme zu handeln scheinen, aber lediglich komplexe Muster erkennen und darauf reagieren.

Eine KI, die auf Kundenanfragen antwortet, aber keine eigenen Ziele verfolgt, bleibt im klassischen Rahmen.

Ein System hingegen, das Ziele priorisiert, Strategien auswählt und sich selbstständig anpasst, überschreitet diese Schwelle.

Ein einzelner Agent mag bereits eine Herausforderung darstellen, doch spannend wird es, wenn viele Agenten miteinander interagieren.

In sogenannten Multiagentensystemen koordinieren sich mehrere Einheiten, um eine gemeinsame Aufgabe zu lösen.

Ein Beispiel findet sich in Smart Grids: Hier agieren Haushalte, Stromspeicher und Versorger als Agenten, die Angebot und Nachfrage dynamisch aushandeln.

Ähnliche Modelle kommen in der Verkehrssteuerung, beim autonomen Fahren oder in Simulationsumgebungen zur Anwendung.

Die Herausforderung liegt in der Balance zwischen Kooperation und Wettbewerb, ein Feld, das auch Spieltheorie, Soziologie und Ethik berührt.

Je autonomer Systeme werden, desto dringlicher wird die Frage nach Kontrolle, Vertrauen und Transparenz.

Ein KI-Agent, der Kreditvergaben vorschlägt oder Diagnosen erstellt, ist nicht nur ein technisches System, sondern Teil eines sozialen Gefüges.

Wer haftet für Fehlentscheidungen? Welche Informationen werden berücksichtigt? Und wie nachvollziehbar sind die Entscheidungen?

Agenten, die mit Menschen interagieren, müssen Vertrauen aufbauen.

Dies gelingt durch erklärbares Verhalten, konsistente Ergebnisse und lernfähige Strukturen.

In der Praxis bedeutet das: Systeme müssen nicht nur "funktionieren", sondern auch kommunizieren können, etwa durch erklärbare Empfehlungen oder adaptive Dialoge.

Ein zukunftsweisender Gedanke ist die "Individuation" von Agenten, die Idee, dass ein Agent nicht nur funktional, sondern auch individuell geprägt ist.

Dies betrifft Lernhistorien, Verhaltensprofile und sogar moralische Entscheidungsrahmen.

Ein solcher Agent ist nicht mehr bloß ein Modul im System, sondern entwickelt sich als eigenständige Entität weiter.

Damit stellt sich eine tiefere Frage: Inwieweit kann ein KI-Agent ein Subjekt im Sinne digitaler Handlungsträger sein?

Während der rechtliche Diskurs darüber noch in den Kinderschuhen steckt, bewegen sich technische Entwicklungen längst auf diese Ebene zu.

Beispiele für KI-Agenten sind Chatbots, digitale Sprachassistenten und soziale Roboter, die menschenähnliche Eigenschaften aufweisen können.

Sie können auch darauf ausgelegt sein, emotionale Signale zu erkennen und auf eine Weise zu reagieren, die Empathie nachahmt.

Agent: Ein Akteur, der selbstständig in einer Umgebung agiert. In der Informatik bezeichnet ein Agent ein System, das wahrnimmt, Entscheidungen trifft und handelt, um ein Ziel zu erreichen.

Autonomie: Die Fähigkeit eines Systems, ohne direkte Steuerung von außen eigene Entscheidungen zu treffen. Autonome Systeme handeln selbstgesteuert auf Basis ihrer Programmierung und Wahrnehmung.

KI-Agent: Ein technisches System mit einer gewissen Selbstständigkeit, das mithilfe künstlicher Intelligenz Aufgaben bearbeitet. Es kann Informationen aufnehmen, verarbeiten, daraus Schlüsse ziehen und entsprechende Handlungen ausführen.

Multiagentensystem (MAS): Ein System, in dem mehrere Agenten gleichzeitig in einer gemeinsamen Umgebung agieren. Diese Agenten können miteinander kooperieren, kommunizieren oder auch konkurrieren.

Wahrnehmung: Die Fähigkeit eines Agenten, Daten aus seiner Umgebung zu erfassen, etwa durch Sensoren, Kameras oder Schnittstellen zu digitalen Systemen.

Entscheidungsmodell: Ein internes Regel- oder Lernsystem, das einem Agenten hilft, aus verschiedenen Handlungsmöglichkeiten die passende auszuwählen. Oft basiert es auf Wahrscheinlichkeiten, Regeln oder maschinellem Lernen.

Handlungsraum: Die Menge an möglichen Aktionen, die einem Agenten in einer gegebenen Situation zur Verfügung stehen.

Zielorientierung: Ein zentrales Merkmal von Agenten: Sie handeln nicht beliebig, sondern mit dem Zweck, ein definiertes Ziel zu erreichen oder eine Aufgabe zu erfüllen.

Reinforcement Learning (Verstärkendes Lernen): Ein Verfahren des maschinellen Lernens, bei dem ein Agent durch Rückmeldungen aus der Umgebung lernt, welche Handlungen zu guten Ergebnissen führen.

Adaptivität: Die Fähigkeit eines Systems, sich an veränderte Bedingungen oder neue Informationen anzupassen, etwa durch Lernen aus Erfahrungen.

Koordination: Ein Mechanismus in Multiagentensystemen, der sicherstellt, dass Agenten effizient zusammenarbeiten oder Konflikte vermeiden, etwa bei der Aufgabenteilung oder Ressourcenverteilung.

Erklärbarkeit (Explainability): Die Eigenschaft eines KI-Systems, seine Entscheidungen so darzulegen, dass sie für Menschen nachvollziehbar sind. Dies ist besonders wichtig für Vertrauen und Kontrolle.

Subjektstatus (im digitalen Kontext): Eine theoretische Idee aus der Ethik und Rechtsprechung, die fragt, ob sehr autonome digitale Agenten als eigene „Subjekte“ mit Rechten oder Pflichten gelten könnten.

KI-Agenten können Konzepte verstehen, durch die Verarbeitung gespeicherter Daten und Algorithmen Schlussfolgerungen ziehen, sich durch ihren Betrieb verbessern und immer genauere Hypothesen aufstellen.

KI-Agenten sind keine Science-Fiction-Konstrukte, sondern operative Akteure in heutigen Systemlandschaften.

Sie nehmen wahr, analysieren, entscheiden, und formen damit Prozesse, die früher ausschließlich in menschlicher Hand lagen.

Das eröffnet neue Möglichkeiten, stellt uns aber zugleich vor alte Fragen in neuer Gestalt: Wer trägt Verantwortung? Wie definieren wir Handlungsmacht? Und wie gestalten wir Systeme, die mit uns, nicht über uns, entscheiden?

Machen Sie sich mit den wichtigsten Begriffen der Künstlichen Intelligenz vertraut.

KI Glossar von A bis ZKI-Entwicklung und ihre Auswirkungen weltweit